Retrieval augmented generation — um problema de busca

A busca é uma infraestrutura essencial para trabalhar com grandes modelos de linguagem (LLMs) e criar as melhores experiências de IA generativa. Você tem uma chance de pedir a um LLM para fornecer a resposta certa com seus dados, então a relevância é crucial. Fundamente seus LLMs com retrieval augmented generation (RAG) usando Elastic.

Experimente este aprendizado prático e em ritmo próprio para aprender a criar um aplicativo RAG.

Experimente a aprendizagem práticaIncorpore o RAG em seus apps e experimente diferentes LLMs com um banco de dados vetorial.

Saiba mais sobre o Elasticsearch LabsSiga este guia para implementar um app de chatbot RAG.

Veja o guiaCONFIADO PELA FORTUNE 500 PARA IMPULSIONAR A INOVAÇÃO EM IA GERATIVA

Prepare seus dados para o RAG

O RAG amplia o poder dos LLMs acessando dados proprietários relevantes sem necessidade de retreinamento. Ao usar RAG com a Elastic, você se beneficia de:

- Técnicas de busca de última geração

- Seleção fácil de modelos e capacidade de trocar modelos sem esforço

- Acesso seguro a documentos e controle baseado em funções para garantir que seus dados permaneçam protegidos

Transforme as experiências de busca

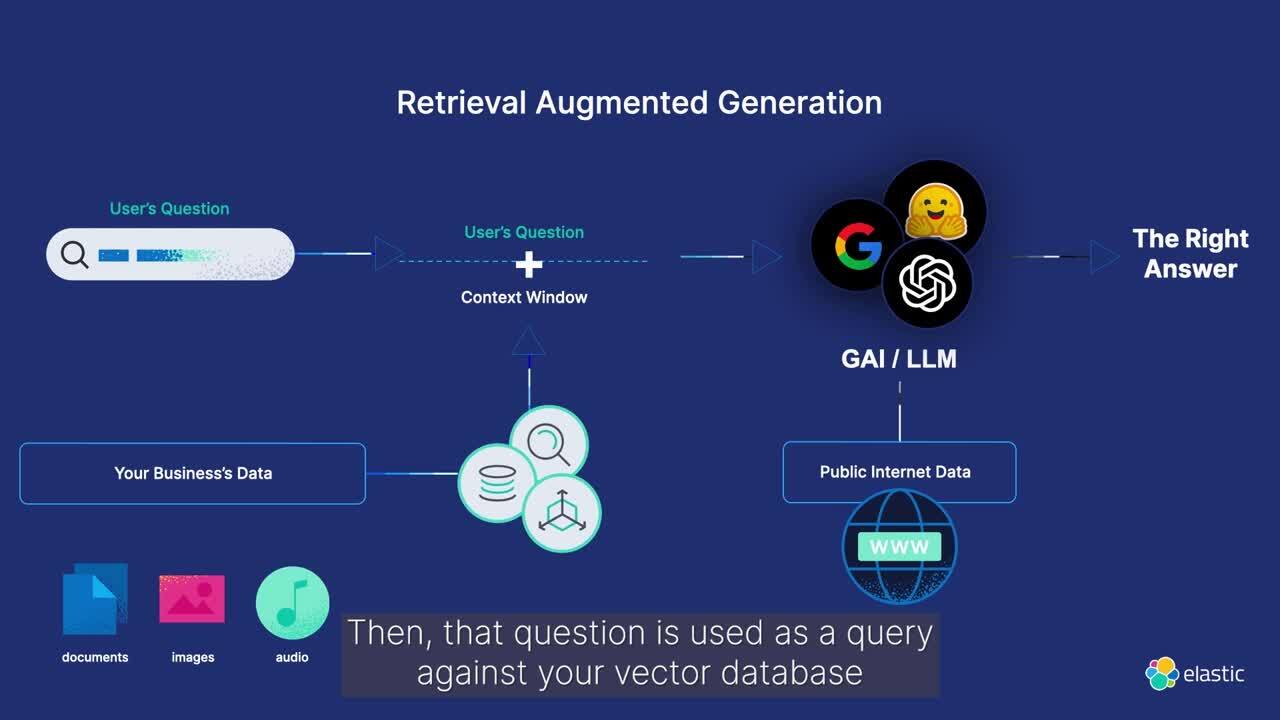

O que é a retrieval augmented generation (RAG)?

A retrieval augmented generation (RAG) é um padrão que aprimora a geração de texto integrando informações relevantes de fontes de dados proprietárias. Ao fornecer contexto específico do domínio ao modelo generativo, a RAG melhora a precisão e a relevância das respostas de texto geradas.

Utilize o Elasticsearch para janelas de contexto de alta relevância que utilizam seus dados proprietários para melhorar a saída do LLM e fornecer as informações em uma experiência conversacional segura e eficiente.

COMO A RAG FUNCIONA COM A ELASTIC

Aprimore seus fluxos de trabalho de RAG com o Elasticsearch

Descubra como o uso do Elastic para fluxos de trabalho de RAG aprimora as experiências de IA generativa. Sincronize facilmente com informações em tempo real usando fontes de dados proprietárias para obter as melhores e mais relevantes respostas de IA generativa.

O pipeline de inferência de machine learning utiliza processadores de ingestão do Elasticsearch para extrair embeddings de forma eficiente. Combinando de forma integrada buscas de texto (correspondência BM25) e vetoriais (kNN), ele recupera documentos com as melhores pontuações para a geração de respostas contextualizadas.

CASO DE USO

Serviço de perguntas e respostas que opera no seu conjunto de dados privado

Implemente experiências de perguntas e respostas usando RAG, desenvolvido pelo Elasticsearch como um banco de dados vetorial.

O Elasticsearch é o banco de dados vetorial mais amplamente implantado

Copie para testar localmente em dois minutos

```

curl -fsSL https://elastic.co/pt/start-local

``` | shBusca por IA — em ação

Veja como as organizações estão criando aplicações de busca com IA para melhorar a experiência do cliente e ajudar os usuários a encontrar exatamente o que estão procurando.

Cliente em destaque

A Consensus atualiza a plataforma de pesquisa acadêmica com busca semântica avançada e ferramentas de IA da Elastic.

Cliente em destaque

A Docusign leva a IA generativa para clientes em todo o mundo com a Elastic.

Cliente em destaque

A Georgia State University aumenta os insights de dados e explora maneiras de ajudar os alunos a solicitar auxílio financeiro com busca baseada em IA.

Perguntas frequentes

A Retrieval-Augmented Generation (comumente chamada de RAG) é um padrão de processamento de linguagem natural que permite que as empresas pesquisem fontes de dados proprietárias e forneçam contexto que fundamenta grandes modelos de linguagem. Isso possibilita respostas mais precisas e em tempo real em aplicações de IA generativa.

Quando implementado de forma otimizada, a RAG fornece acesso seguro a dados proprietários relevantes e específicos do domínio em tempo real. Ela pode reduzir a incidência de alucinações em aplicações de IA generativa e aumentar a precisão das respostas.

RAG é uma técnica complexa que depende da:

- Qualidade dos dados alimentados nele

- Eficácia da recuperação de busca

- Segurança dos dados

- Capacidade de citar as fontes das respostas de IA generativa para ajustar finamente os resultados

Além disso, escolher a IA generativa correta ou o modelo de linguagem de grande porte (LLM) em um ecossistema em rápida evolução pode representar desafios para as organizações. E os custos, o desempenho e a escalabilidade associados à RAG podem prejudicar a velocidade com que as empresas lançam aplicativos em produção.

O Elasticsearch é uma plataforma de IA flexível e um banco de dados vetorial que pode indexar e armazenar dados estruturados e não estruturados de qualquer fonte. Ele fornece recuperação de informações eficiente e personalizável e vetorização automática em bilhões de documentos. Além disso, oferece segurança empresarial com controle de acesso em nível de função e documento. A Elastic também oferece uma interface padrão para acessar inovações em um ecossistema GenAI em expansão, incluindo hiperescaladores, repositórios de modelos e frameworks. Por fim, a Elastic é comprovada em ambientes de produção em escala, atendendo a mais de 50% do mercado Fortune 500. Veja como criar sistemas RAG no Elastic com o Playground.

A Elastic oferece busca entre clusters (CCS) e replicação entre clusters (CCR) para ajudar você a gerenciar e proteger dados em ambientes privados, locais e na nuvem. Com o CCS e o CCR, você consegue:

- Garantir alta disponibilidade

- Manter a conformidade com as regulamentações globais de proteção de dados

- Alcançar a privacidade e a soberania dos dados

- Crie uma estratégia eficaz de recuperação de desastres

A Elastic também oferece controle de acesso baseado em funções e em nível de documento que autoriza clientes e funcionários a receberem respostas apenas com dados aos quais têm acesso. E nossos usuários podem obter insights a partir de observabilidade e monitoramento abrangentes para qualquer implantação.