Faça a ingestão de dados diretamente do Google Pub/Sub no Elastic usando o Google Dataflow

Hoje temos a satisfação de anunciar o mais recente desenvolvimento em nossa parceria contínua com o Google Cloud. Agora desenvolvedores, engenheiros de confiabilidade do site (SREs) e analistas de segurança podem ingerir dados do Google Pub/Sub no Elastic Stack com apenas alguns cliques no Google Cloud Console. Ao aproveitar os modelos do Google Dataflow, a Elastic facilita a transmissão de eventos e logs de serviços do Google Cloud como Google Cloud Audit, VPC Flow ou firewall para o Elastic Stack. Isso permite que os clientes simplifiquem a arquitetura de pipeline de dados, eliminem a sobrecarga operacional e reduzam o tempo necessário para a solução de problemas.

Muitos desenvolvedores, SREs e analistas de segurança que usam o Google Cloud para desenvolver aplicações e configurar sua infraestrutura também usam o Elastic Stack para solucionar problemas, monitorar e identificar anomalias de segurança. O Google e a Elastic trabalharam juntos para fornecer uma maneira descomplicada de ingerir logs e eventos de aplicações e infraestrutura dos serviços do Google Cloud no Elastic. E tudo isso é possível com apenas alguns cliques no Google Cloud Console, sem precisar instalar agentes de dados.

Neste post do blog, mostraremos como começar com a ingestão de dados do Google Pub/Sub no Elastic Stack sem agente usando o Google Dataflow.

Elimine o trabalho extra

Pub/Sub é um popular serviço de mensagens assíncrono e sem servidor usado para transmitir dados do Google Operations (antigo Stackdriver), de aplicações criadas com os serviços do Google Cloud ou outros casos de uso que envolvem a transmissão de pipelines de integração de dados. Para fazer a ingestão de logs do Google Cloud Audit, do VPC Flow ou de firewall para soluções analíticas de terceiros como o Elastic Stack, é necessário que esses logs sejam enviados primeiro para o Google Operations e, em seguida, para o Pub/Sub. Depois que os logs estão no Pub/Sub, um usuário do Google Cloud deve decidir sobre o método de ingestão para enviar as mensagens armazenadas no Google Pub/Sub para soluções analíticas de terceiros.

Uma opção popular para usuários do Google e da Elastic é instalar o Filebeat, o Elastic Agent ou o Fluentd em uma VM (máquina virtual) do Google Compute Engine e, em seguida, usar um desses agentes de dados para enviar dados do Pub/Sub para o Elastic Stack. O provisionamento de uma VM e a instalação de agentes de dados exigem um trabalho adicional de processo e gerenciamento. A capacidade de pular essa etapa e ingerir dados diretamente do Pub/Sub no Elastic é valiosa para muitos usuários, especialmente quando isso pode ser feito com alguns cliques no Google Cloud Console. Agora isso é possível por meio de um menu suspenso no Google Dataflow.

Simplifique a ingestão de dados

O Google Dataflow é um serviço de mensagens assíncrono e sem servidor baseado no Apache Beam. O Dataflow pode ser usado em vez do Filebeat para enviar logs diretamente do Google Cloud Console. As equipes do Google e da Elastic trabalharam juntas para desenvolver um modelo do Dataflow pronto para uso para enviar logs e eventos do Pub/Sub para o Elastic. Esse modelo substitui o processamento lightweight, como a transformação do formato de dados anteriormente concluída pelo Filebeat de uma maneira sem servidor — sem outras alterações para quem usava anteriormente o pipeline de ingestão do Elasticsearch.

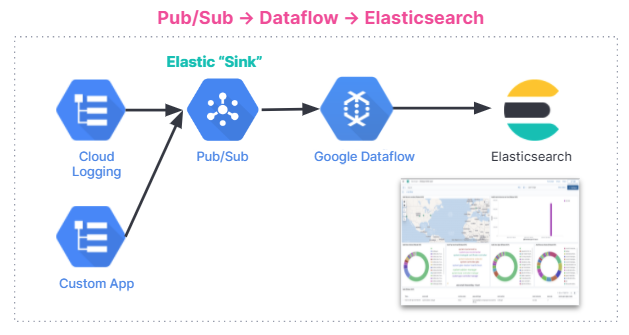

Aqui está um resumo do fluxo de ingestão de dados. A integração funciona para todos os usuários, independentemente de estarem usando o Elastic Stack no Elastic Cloud, o Elastic Cloud no Google Cloud Marketplace ou um ambiente autogerenciado.

Começar

Nesta seção, entraremos em um tutorial passo a passo sobre como começar a usar o modelo do Dataflow para analisar logs de auditoria do GCP no Elastic Stack.

Os logs de auditoria contêm informações que ajudam a responder às perguntas “onde, como e quando” das mudanças operacionais que acontecem na sua conta do Google Cloud. Com o nosso modelo do Pub/Sub, você pode transmitir logs de auditoria do GCP para o Elasticsearch e coletar insights em segundos.

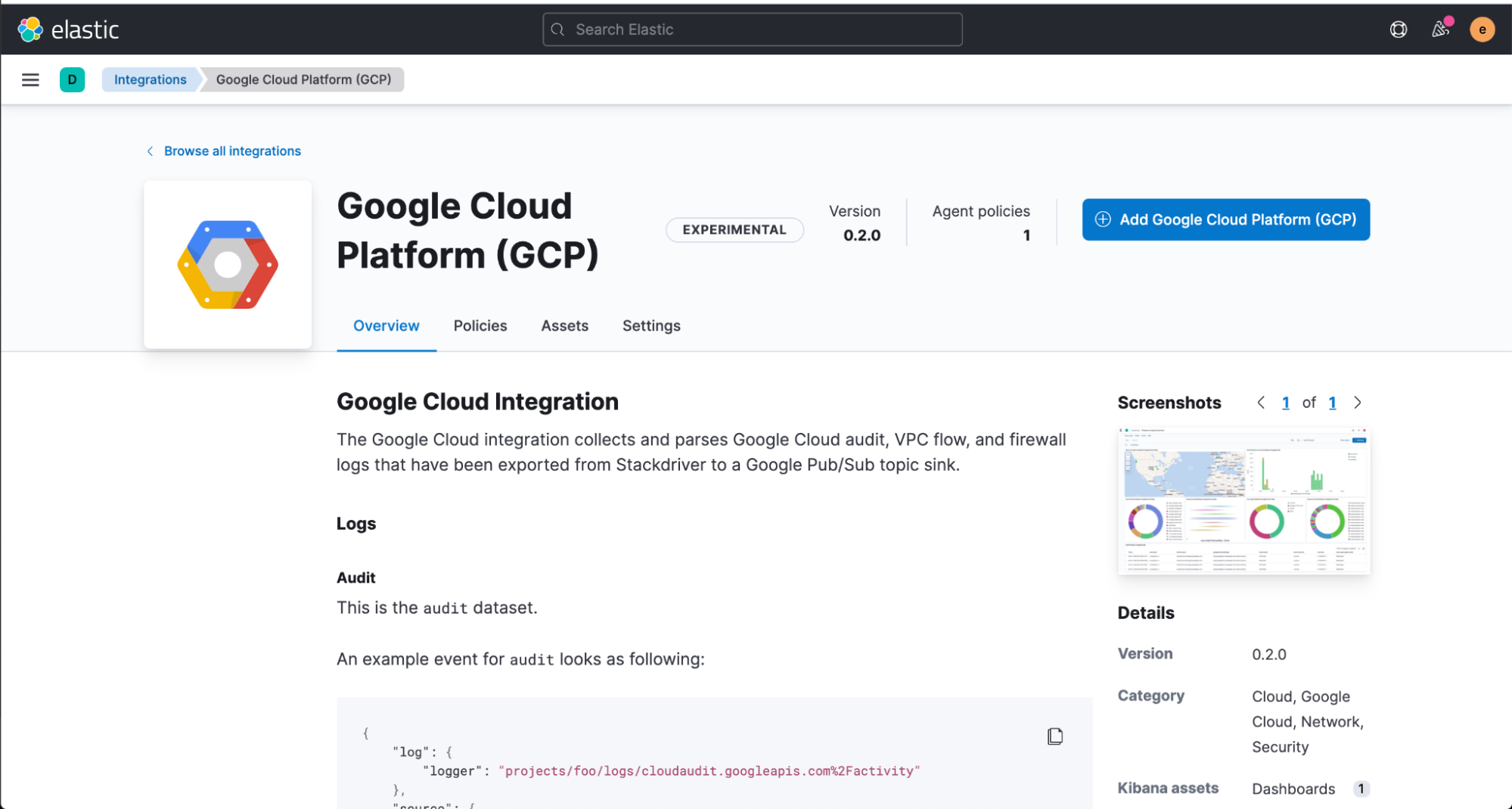

Começaremos instalando a integração do GCP da Elastic diretamente da interface Web do Kibana, que contém dashboards pré-criados, configurações de nó de ingestão e outros ativos que ajudam a obter o máximo dos logs de auditoria que você ingere.

Antes de configurar o modelo do Dataflow, você terá de criar um tópico e uma assinatura do Pub/Sub no Google Cloud Console, onde você pode enviar seus logs do Google Operations Suite.

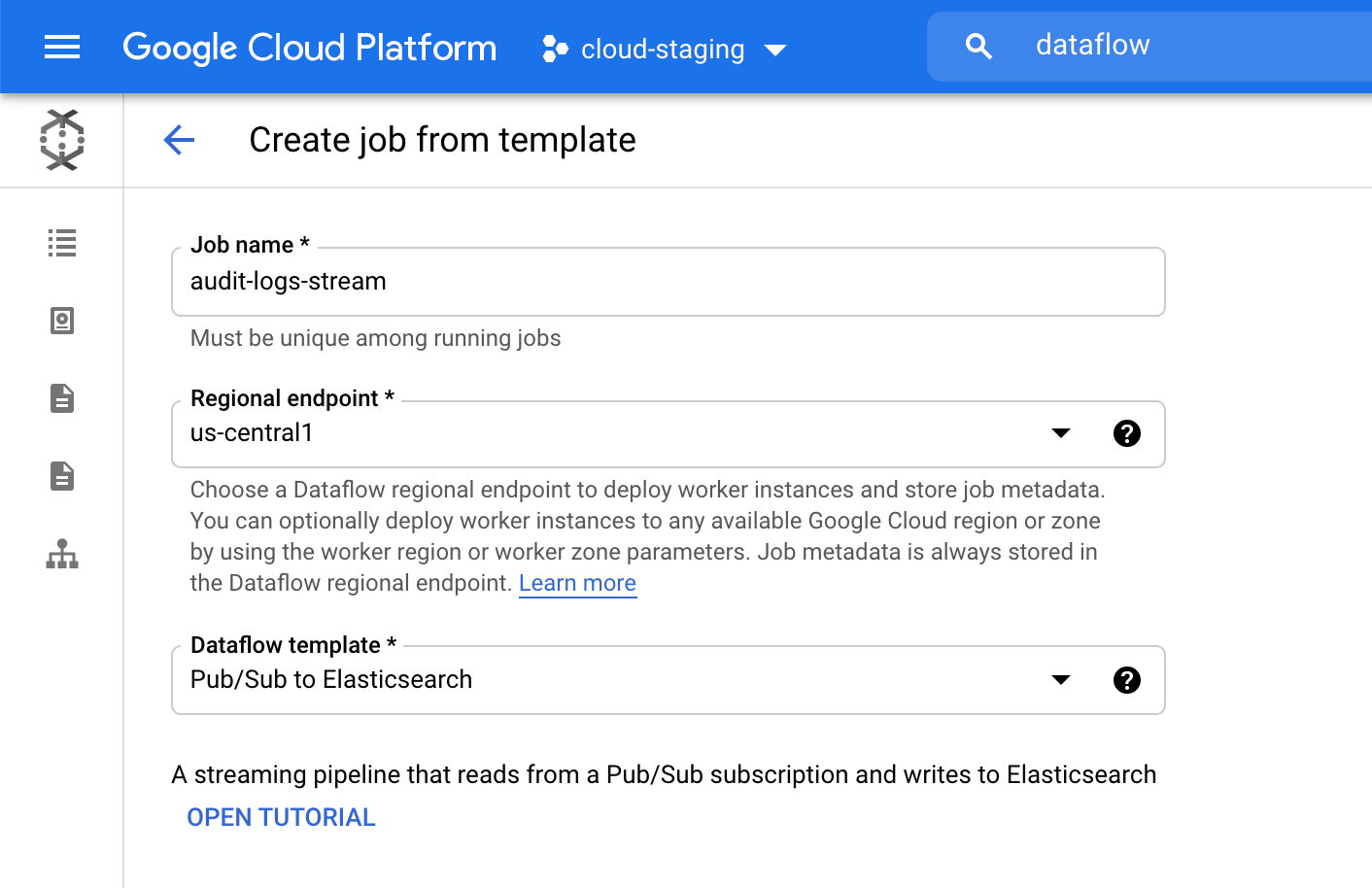

Em seguida, navegue até o Google Cloud Console para configurar o nosso trabalho do Dataflow.

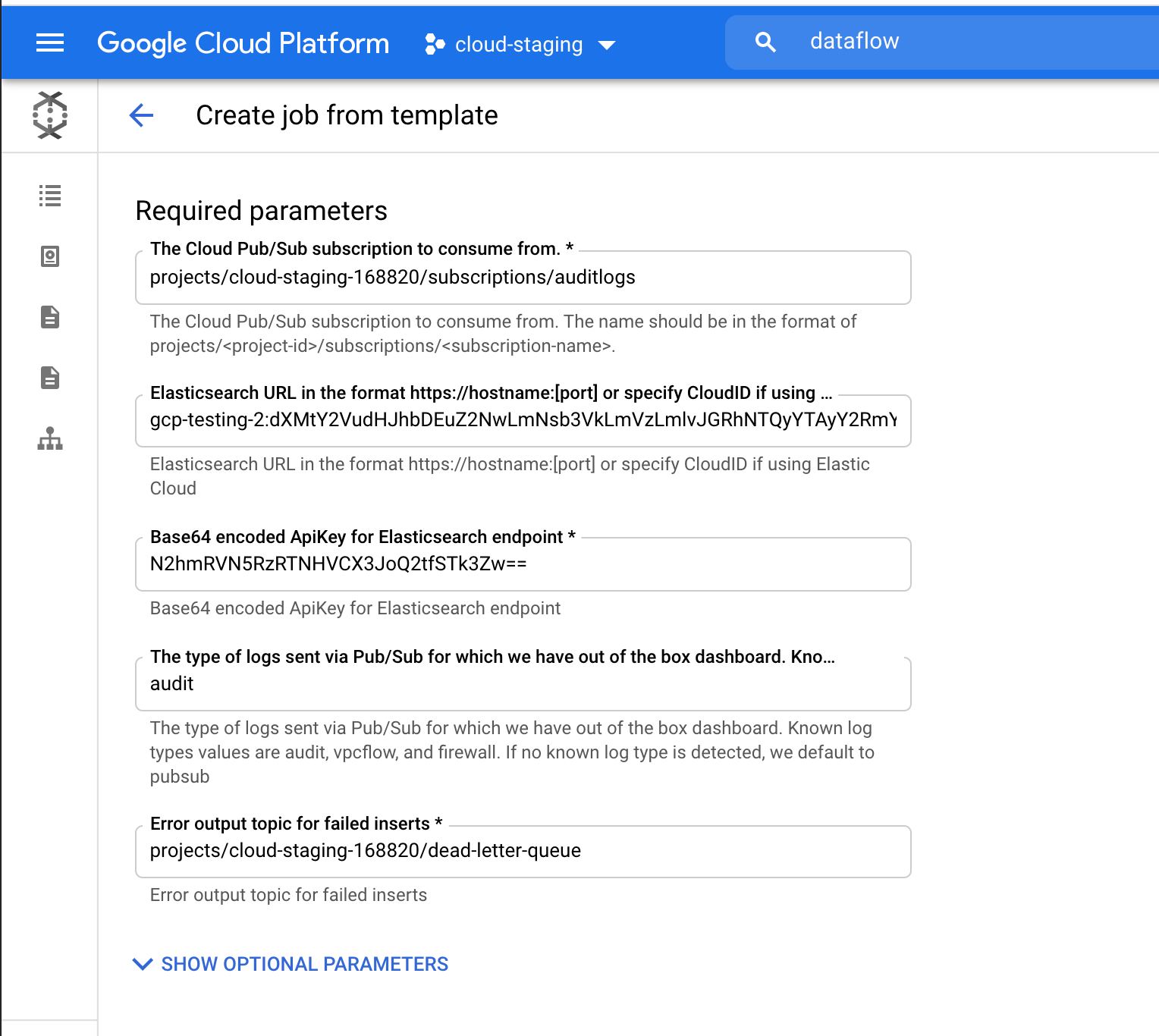

No produto Dataflow, clique em “Create job from template” (Criar trabalho a partir do modelo) e selecione “Pub/Sub to Elasticsearch” (Do Pub/Sub para o Elasticsearch) no menu suspenso do modelo do Dataflow.

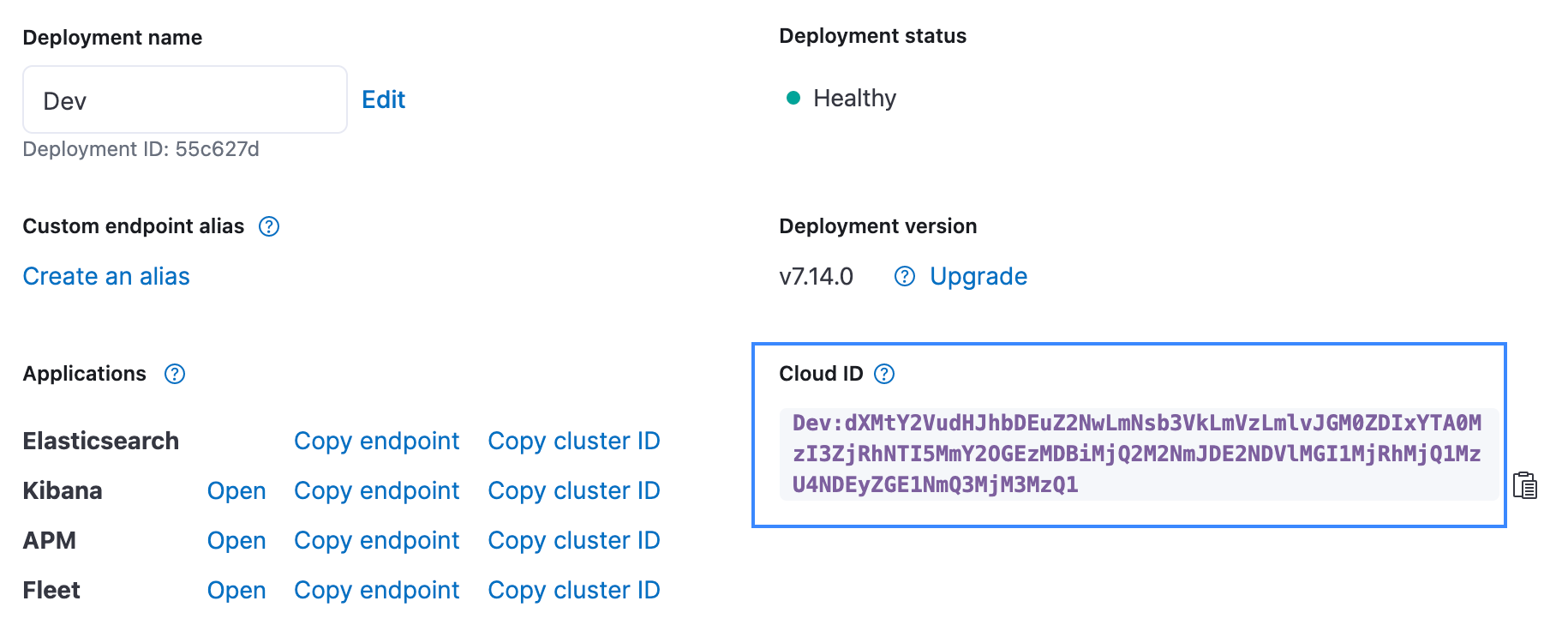

Preencha os parâmetros necessários, incluindo seu Cloud ID e a chave de API codificada em Base64 para Elasticsearch. Como estamos transmitindo logs de auditoria, adicione “audit” como um parâmetro de tipo de log. O Cloud ID pode ser encontrado na UI do Elastic Cloud, conforme mostrado abaixo. A chave da API pode ser criada usando a API para criar uma chave de API.

Clique em “Run Job” (Executar trabalho) e aguarde o Dataflow executar o modelo, o que leva alguns minutos. Como você pode ver, não é necessário sair do Google Cloud Console nem gerenciar agentes!

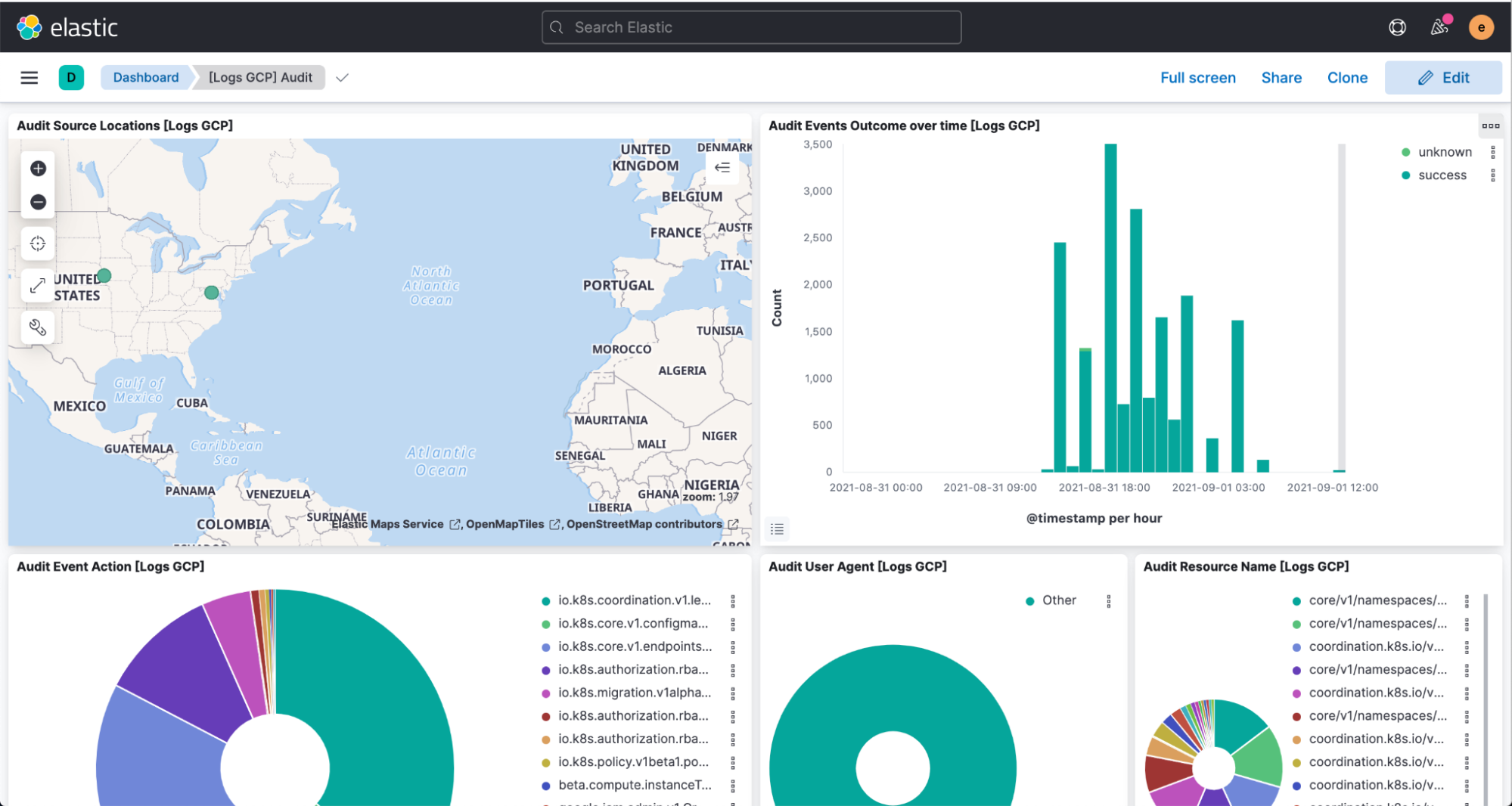

Agora navegue até o Kibana para ver seus logs analisados e visualizados no dashboard [Logs GCP].

Resumo

A Elastic está sempre buscando facilitar e simplificar para os clientes executarem onde quiserem e usarem o que quiserem — e essa integração com o Google Cloud é o exemplo mais recente disso. O Elastic Cloud estende o valor do Elastic Stack, permitindo que os clientes façam mais e mais rápido, o que o torna a melhor maneira de experimentar a nossa plataforma. Para obter mais informações sobre a integração, acesse a documentação do Google. Para começar a usar o Elastic no Google Cloud, acesse o Google Cloud Marketplace ou o website elastic.co.